学术交流

Wizard of Search Engine: Access to Information through Conversations with Search Engines

作者:任鹏杰,刘中坤,宋晓萌,田洪涛,陈竹敏,任昭春,Maarten de Rijke 来源:The 44th International ACM SIGIR Conference on Research and Development in Information Retrieval (SIGIR), 2021 链接:

- 论文:

- 代码:

- 数据集:

- 数据集构建UI:

撰写:田洪涛 校稿:任鹏杰

对话式信息获取

什么是对话式信息获取(Conversational Information Seeking,CIS)呢?我们知道传统的搜索引擎采用“关键字-检索结果页”的范式,即根据用户所输关键词返回检索结果页列表。然后用户遍历检索结果页以获取所需的信息。但这种范式比较适合处理具有简单意图的问题,对于复杂意图的情况,如用户想要了解多个查询对象的前因后果、对比分析时,或者当用户对所查询对象知之甚少时,这种范式就显得不够灵活。

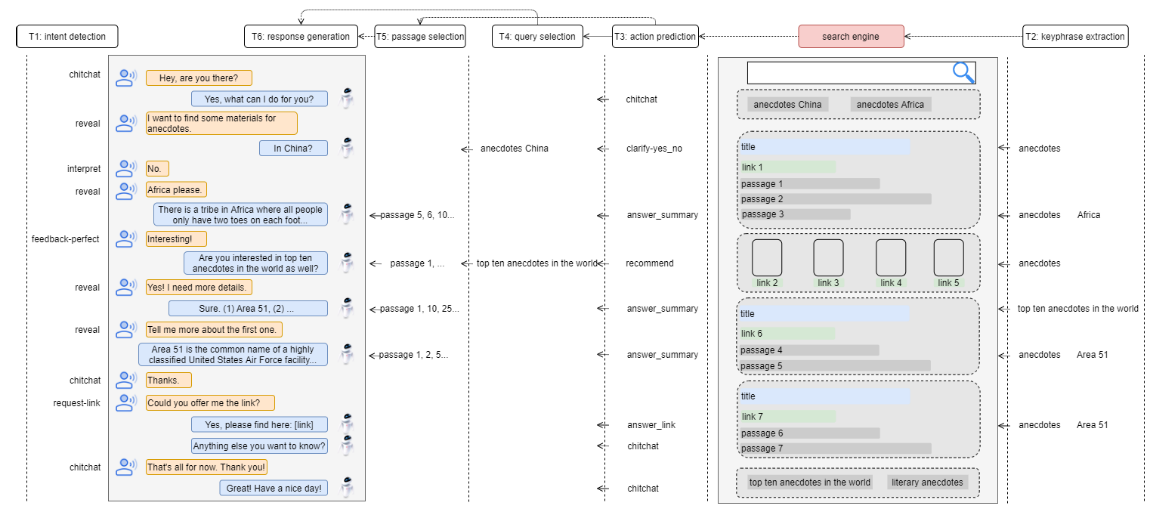

图 1. 对话式信息获取.

对话式信息获取是一种新型的与搜索引擎交互的范式。如图1所示,它允许用户可以直接与搜索引擎对话来表达自己的意图。这种范式可以通过对话交互更好地捕获用户意图,并且用户可以直接得到答案而不必遍历检索结果。对话式信息获取已成为信息检索领域中的一个新兴研究领域,吸引了越来越多的研究者。但目前该任务缺少合适的资源,相关工作局限于对理论和概念框架的研究,因此目前对该领域的研究还不够充分。

因此,在该工作中,作者从三个方面来展开了对对话式信息获取的研究:

- 构建了一个基准数据集(Wizard of Search Engine, WISE),利用它可以对对话式信息获取的各个方面进行全面深入的研究;

- 构建了由6个子任务组成的管道式框架,如图1所示,包括意图识别(Intent Detection,ID)、关键词提取(Keyphrase Extraction,KE)、动作预测(Action Prediction,AP)、查询选择(Query Selection,QS)、篇章选择(Passage Selection,PS)和回复生成(Response Generation,RG);

- 设计了一个能够针对所提出的管道式框架的“预训练-微调”学习策略,以充分利用现有相关数据集来降低模型对目标数据集在规模上的需求。

用户意图/系统动作及数据集

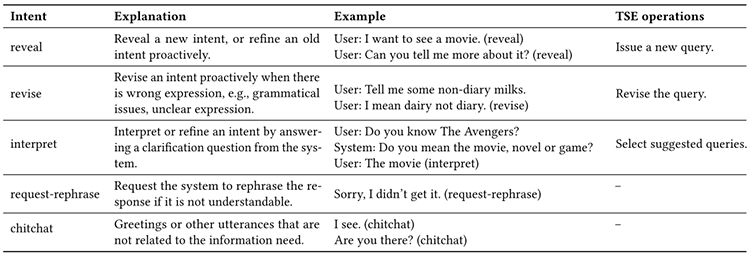

用户意图集定义及解释如图2所示。

图2. 用户意图集定义.

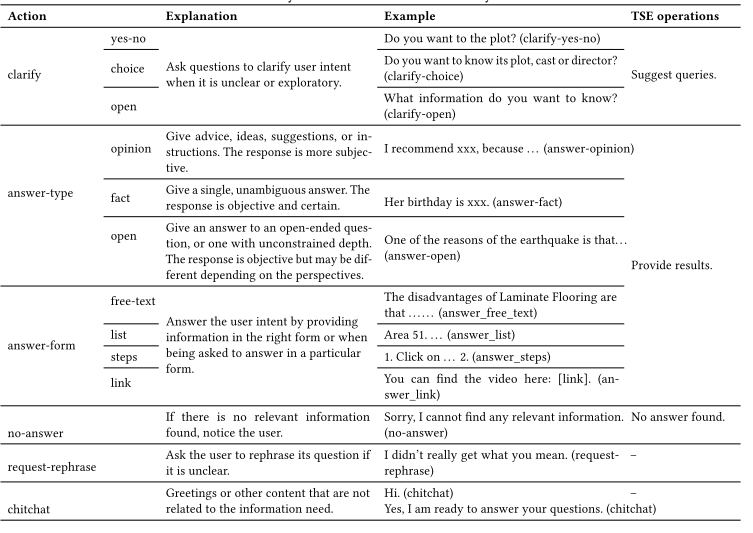

系统动作集定义及解释如图3所示

图3. 系统动作集定义.

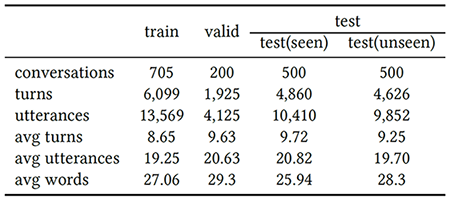

数据构建过程详见论文,数据集统计信息如图4所示。

图4. 数据集统计信息.

管道式框架及子任务

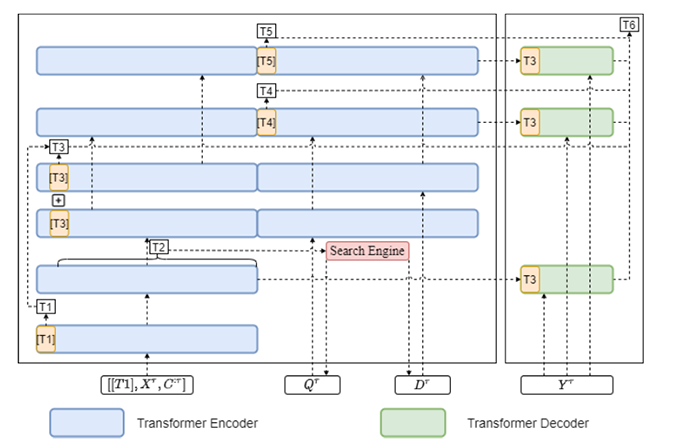

模型的整体框架如图5所示:

图5. 管道式框架.

模型是基于Transformers的,且整体上分为6个模块,分别与6个子任务(意图识别、关键词提取、动作预测、查询选择、篇章选择和回复生成)相对应,建模细节详见论文。

那如何利用现有数据集更好地训练这个模型呢?对此,作者提出使用“预训练-微调”策略来学习模型的参数。在预训练阶段,作者利用了4种相关数据集,以充分利用现有相关数据集来降低模型对目标数据集在规模上的需求,同时,这4种数据集按照目标的不同可以分别预训练不同的模块,如图6所示:

图6. 模型预训练.

微调阶段使用的是本文提出的WISE数据集。

实验

作者在自己划分的数据集上进行了模型的验证。首先做了一组模型在不同策略下的实验,实验结果如图7所示:

图7. 整体结果.

可见,在绝大部分指标上,WISE的效果要远远优于WISE-pretrain(不做预训练)的效果,这说明了预训练对于提升模型效果有很大的作用。另外,使用了ground truth的WISE+GT的RG效果要优于WISE,这说明了数据集中的ID、KE、AP、QS、PS等人工标签能有效提升RG的表现效果。

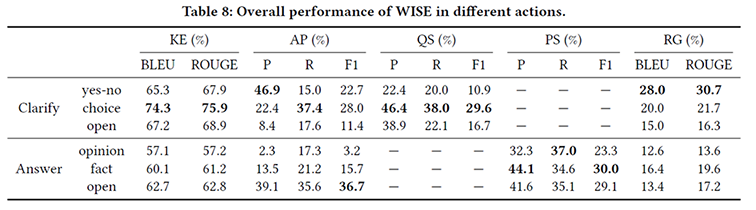

另外,作者还分析了模型在不同系统动作上的表现效果,如下图8所示:

图8. 不同系统动作结果.

可见不同模块对于最终的生成效果的影响是多方面的,最终的生成回复的效果还受用户问题的难易程度的影响。

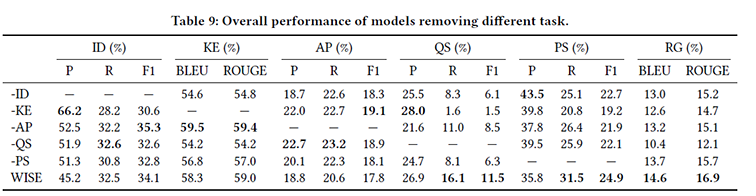

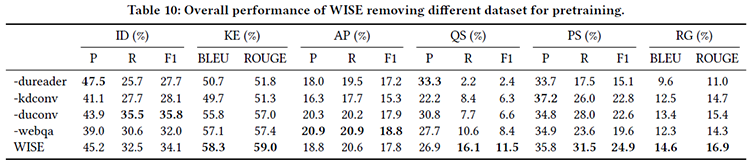

作者还做了分析不同模块对最后生成效果影响的消融实验,也做了分析不同预训练数据集作用的实验,如图9所示:

图9. 子任务消融实验.

图10. 预训练消融实验.

可见,去除模型的某一部分,或不使用某一种预训练数据集,都会对模型最后的生成效果产生影响,使得生成的效果产生不同程度的降低。这进一步说明了不同模块的有效性,以及各个预训练数据集的有效性。