学术交流

山东大学信息检索实验室师生2篇论文获WSDM 2024录用

2023年11月29日

近日,山东大学计算机科学与技术学院信息检索实验室师生撰写的2篇论文被WSDM 2024录用。WSDM(Web Search and Data Mining)是信息检索与数据挖掘领域的国际顶级会议,CCF B类会议。WSDM 2024将在2024年3月4日-3月8日在墨西哥梅里达(Mérida, México)举行。

录用的文章如下:

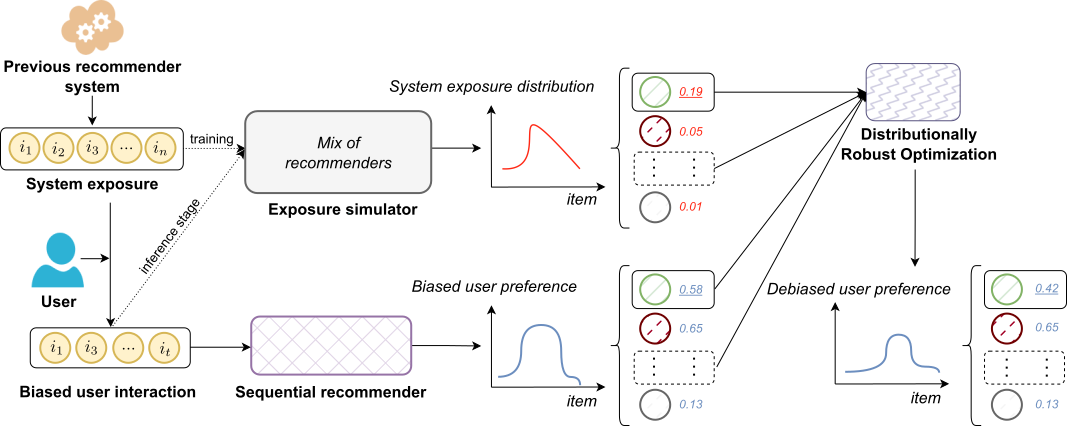

标题:Debiasing Sequential Recommenders through Distributionally Robust Optimization over System Exposure 作者:杨纪元,丁玥,王一丹,任鹏杰,陈竹敏,蔡飞,马军,张瑞,任昭春,辛鑫 简介:序列推荐(SR)模型通常经过用户-物品的交互进行训练,这种交互受到系统曝光偏差的影响,导致从有偏的 SR 模型中学习到的用户偏好与真实的用户偏好并不完全一致。现有的去偏方法并未充分利用系统曝光数据,推荐性能次优而且存在方差大的问题。本文提出了一种通过对系统曝光数据进行分布鲁棒优化(DRO)的方法对SR模型进行去偏,关键思路是利用 DRO 优化不确定集上的最坏误差,以保护模型免受曝光偏差引起的分布差异。该方法的主要挑战在于如何构建不确定集并避免对有偏样本用户的偏好进行过度估计。此外,由于测试集也可能受到曝光偏差的影响,如何评估模型的去偏差效果也是一个悬而未决的问题。为此,我们首先引入一个在系统曝光数据上训练的曝光模拟器来计算曝光分布,然后将其视为名义分布(nominal distribution)来构造 DRO 的不确定集。然后,我们对那些具有高曝光几率的物品引入惩罚,以避免对有偏样本用户偏好的过度估计。最后,我们设计了一个去偏的自归一化反倾向性评分(SNIPS)评估器,用于评估有偏离线测试集上的去偏效果。我们在两个真实世界的数据集上进行了大量实验,实验结果表明我们提出的方法取得了优越的性能。

图:整体框架图

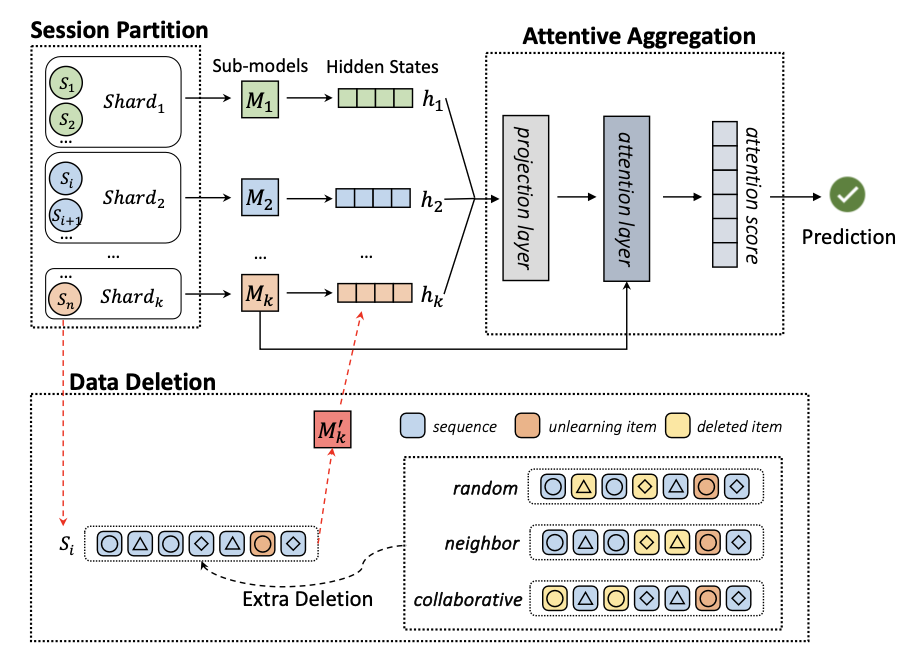

标题:On the Effectiveness of Unlearning in Session-Based Recommendation 作者:辛鑫,杨柳,赵子奇,任鹏杰,陈竹敏,马军,任昭春简介: 在基于会话的推荐系统中,会根据会话中的交互历史预测用户未来的兴趣。有时出于用户隐私或模型性能等原因的考虑,会要求系统进行遗忘学习,即消除某些训练样本的影响。然而,现有的关于遗忘学习的研究并不适合基于会话的推荐。一方面,这些方法无法达到令人满意的遗忘学习效果,因为遗忘的物品与会话中剩余物品之间存在协作相关性和序列连续性。另一方面,在基于会话的推荐场景中,很少有研究对遗忘学习的真实效果进行验证。 在本文中,我们提出了基于会话的推荐遗忘学习框架 SRU,该框架能在基于会话的推荐中实现较高的遗忘学习效率、准确的推荐性能和改善的遗忘学习效果。具体来说,我们首先根据会话之间的相似性将训练会话划分输入到不同的子模型,然后利用基于注意力的聚合层,根据会话与子模型中数据中心点之间的相似性对隐状态进行融合。为了提高遗忘学习效果,我们进一步提出了三种额外数据删除策略,包括协作额外删除(CED)、邻接额外删除(NED)、和随机额外删除 (RED)。此外,我们还提出了一种评估指标,用于衡量数据删除后是否可以继续预测遗忘学习样本,以验证遗忘学习的有效性。我们利用三个具有代表性的基于会话的推荐模型实现了 SRU,并在三个基准数据集上进行了实验,实验结果证明了我们方法的有效性。

图:SRU模型架构