学术交流

山东大学信息检索实验室师生在会议NeurIPS 2023、会议CIKM 2023及期刊TACL发表论文

2023年10月6日

近日,山东大学计算机科学与技术学院信息检索实验室师生撰写的3篇论文分别被会议NeurIPS 2023、会议CIKM 2023以及期刊TACL录用。

录用的文章如下:

Main Conference:

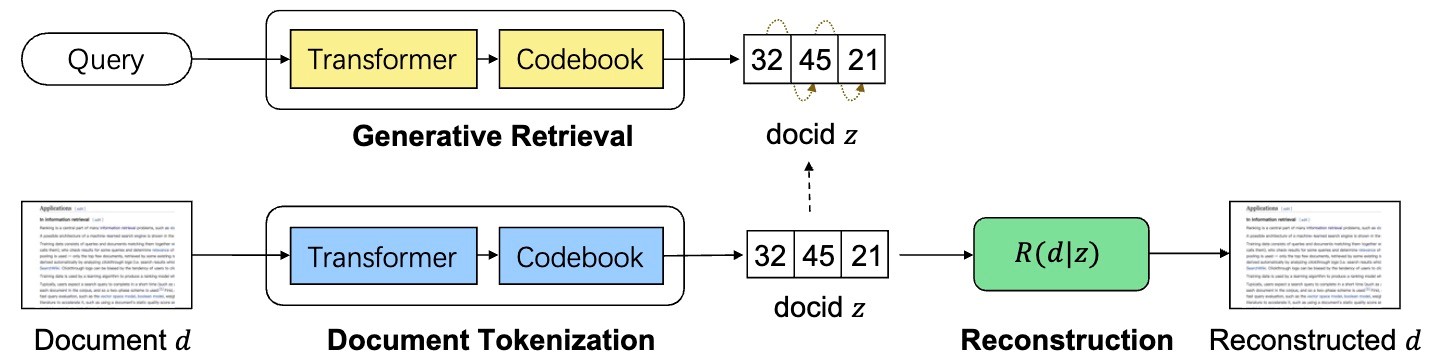

标题:【NeurIPS 2023】Learning to Tokenize for Generative Retrieval 作者:孙维纬, 颜令勇,陈正,王帅强,朱海潮,任鹏杰,陈竹敏,殷大伟,Maarten de Rijke,任昭春 简介:作为信息检索的新范式,生成式检索能够直接使用生成式语言模型(LMs)为给定查询生成排名的文档标识符(docids)列表。而如何为每个文档分配一个唯一的docid是生成式的关键问题,因为它决定了生成性检索模型是否可以通过简单解码其docid来精确检索任何文档。然而,大多数现有方法采用基于规则的标记化,这是特设的,并且泛化性不佳。相比之下,本文提出了一种新颖的文档令牌化学习方法——GENRET,该方法学会将完整的文档语义编码到docids中。具体来说,GENRET通过一种离散自动编码方法学习将文档标记化为短的离散表示(即,docids)。我们进一步开发了一种渐进式训练方案,以建模docids的自回归性质,并采用多样性聚类技术稳定训练过程。基于任何一组文档的语义嵌入式docids,生成性检索模型可以学习仅根据docids与查询的语义相关性生成最相关的docid。我们在NQ320K、MS MARCO和BEIR数据集上进行实验,并验证了方法的有效性。尤其是与生成式检索基线相比,GENRET可以在未见文档上取得显著改进。此外,GENRET也可以在MS MARCO和BEIR上超过基线方法,展示了该方法的泛化能力。

图:我们提出的方法概述如下。所提出的方法利用一个文档令牌化模型(Document Tokenization),将给定的文档转换为一系列离散的标记,即docid。这个过程产生的docid可以被一个重构模型用于重构原始文档。随后,模型采用一个自回归的方式生成文档的docids以完成文档检索。

NeurIPS,全称Annual Conference on Neural Information Processing Systems,是机器学习领域的顶级会议,也是CCF推荐A类会议。其与ICML,ICLR并称为机器学习领域难度最大,水平最高,影响力最强的会议。NeurIPS 2023 计划于今年12月10日至16日在美国路易斯安那新奥尔良召开。

标题:【CIKM 2023】Iteratively Learning Representations for Unseen Entities with Inter-Rule Correlations

作者:王梓涵,赵凯,何永全,陈竹敏,任鹏杰,Maarten de Rijke,任昭春简介: 现有研究工作将知识图谱(KG)广泛用于存储结构化信息,和增强各种下游应用,如问答系统、对话系统、推荐系统,和信息抽取等任务。尽管现有知识图谱往往包含大量的事实信息,但它仍然存在大量的缺失事实。为了对知识图谱进行自动化补全,相关工作提出了知识图嵌入方法(Knowledge graph emebdding),并引起了越来越多的关注。之前的知识图谱表示方法主要直推式地预测缺失事实三元组,要求所有的实体在模型训练阶段出现过。然而,在现实的场景中,知识图谱中的知识范围在不断扩大,原有知识图谱之外的实体(OOKG entities)在不断出现。为了表示这些新出现的实体,大多数传统的知识表示框架不可避免地需要重新训练模型,非常耗时。

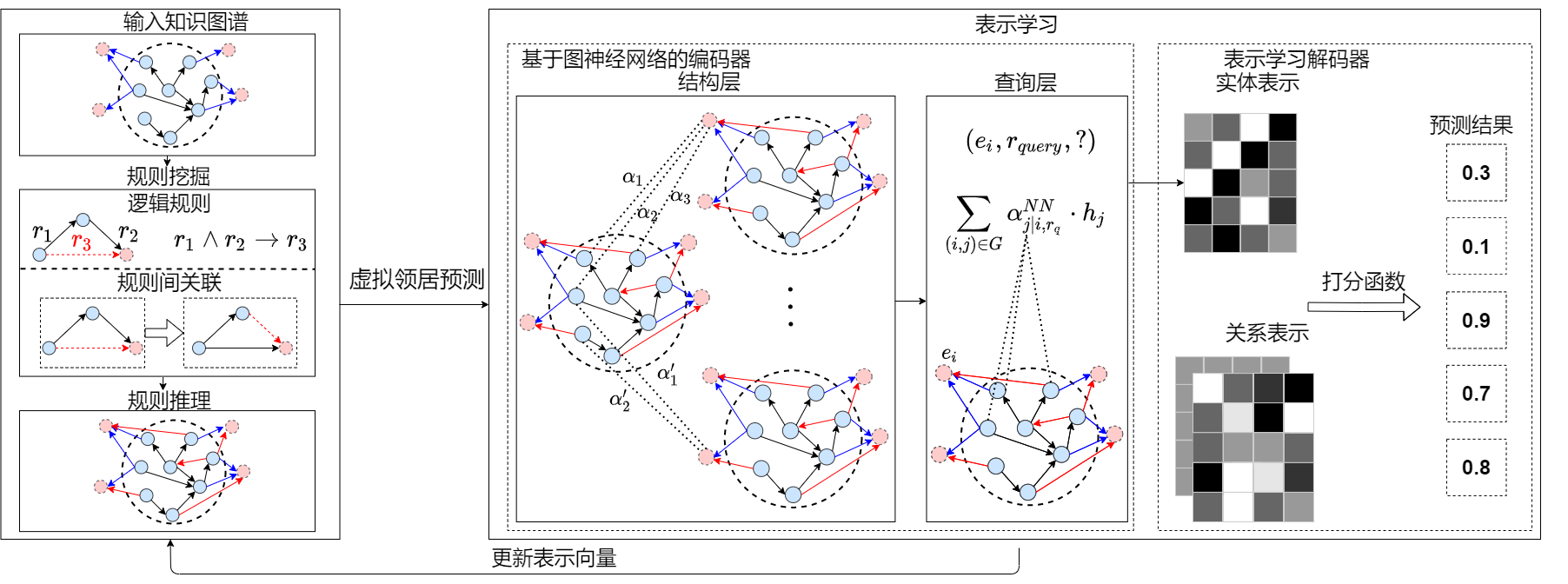

为了解决该问题,一个归纳式知识图谱表示框架亟需建立。为了解决上述技术问题,本工作识别了知识图谱中规则间的关联关系,设计了一个迭代式框架VNC (virtual neighbor network with inter-rule correlations),建模规则挖掘、规则推理、和表示学习三个过程之间的交互信息。如下图所示,VNC框架包括三个阶段:规则挖掘、规则推理,和表示学习。给定可观察的知识图谱,该方法首先从知识图谱中挖掘对应规则,通过路径搜索产生规则池和利用关系表示计算规则置信度。接下来,在规则推理阶段,利用实例化之后的规则预测候选三元组,并构建规则约束的最优化方法计算每个候选三元组的软标签。在此基础上,这些将候选三元组和原来的知识图谱构成新的知识图谱,并输入至基于图神经网络的编码器中。最后,基于表示学习的解码器将关系映射为表示向量,计算缺失事实三元组的成立可能性分数,预测知识图谱中的缺失三元组。在训练阶段,规则挖掘、规则推理,和表示学习三个步骤不断迭代循环,直至收敛。

图:VNC框架图

CIKM,全称ACM International Conference on Information and Knowledge Management,是CCF推荐的B类国际学术会议,也是信息检索和数据挖掘领域顶级学术会议之一。CIKM 2023 计划于今年10月21日至25日在英国召开。

Journal:

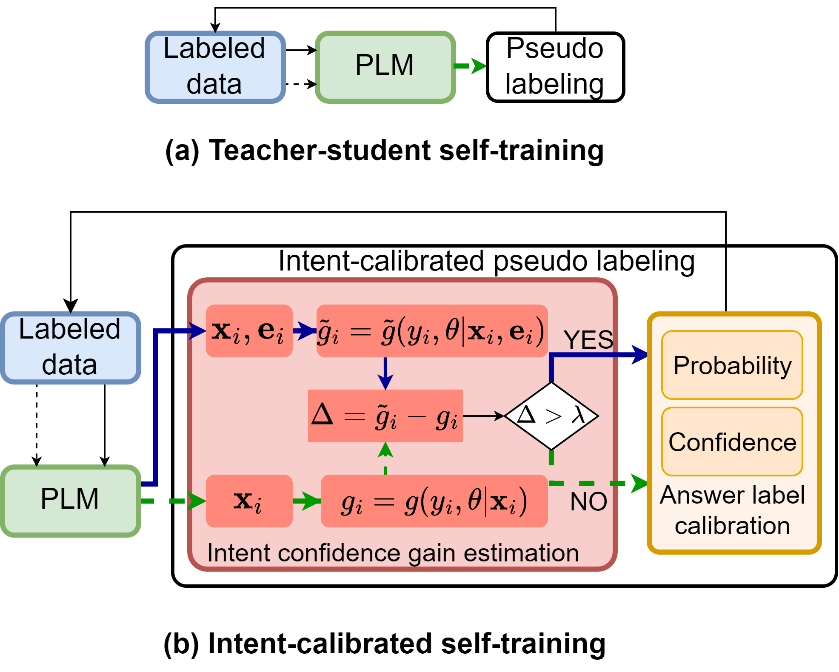

标题:【TACL】Intent-calibrated Self-training for Answer Selection in Open-domain Dialogues 作者:邓文韬,裴家欢,任昭春,陈竹敏,任鹏杰 简介:在开放领域对话中,答案选择(Answer Selection)旨在从候选答案中选择一个准确的答案。最近,答案选择模型的成功取决于使用大量标记数据进行训练。然而,收集大规模有标注数据是一项费时费力的工作。在本文中,我们引入了预测的意图标签,以在自我训练范式中校准答案标签。具体而言,我们提出了意图校准自我训练(ICAST)方法,通过意图校准的答案选择范式来提高伪标签的质量,在这种范式中,我们使用伪意图标签来帮助改进伪标签。我们在两个开放领域对话的基准数据集上进行了大量实验。实验结果表明,在只有1%、5%和10%标注数据的情况下,ICAST能够表现更好。

图: ICAST方法框架图。图a为传统的自训练方法,图b为本文提出的ICAST方法。

TACL,全称Transactions of ACL, 是人工智能领域自然语言处理(Natural Language Processing,NLP)方向权威的国际期刊之一,也是CCF B类及JCR一区期刊,影响因子为17.59。